Jak blokować boty SEO na stronie? Robots.txt.

Chcesz zablokować katalogi, adresy lub konkretne boty na stronie? Wykonasz to samodzielnie za pomocą wgrania pliku robots.txt na serwer. Dowiedz się więcej co to jest i do czego służy robots.txt .

Plik robots.txt - co to jest?

Plik robots.txt to plik tekstowy, umieszczony na serwerze internetowym, który zawiera wpisy informujące roboty wyszukiwarek (ang. crawlers lub spiders) o tym, które strony lub pliki powinny być ignorowane podczas indeksowania strony internetowej. Te wpisy indeksowania są określone przez „niezezwalania” lub „zezwalania” na zachowanie niektórych (lub wszystkich) adresów oraz robotów. Dowiedz się co powinno znajdować się w takim pliku aby zablokować roboty przed indeksowaniem naszych treści.

Co to są boty intenetowe?

Robot internetowy (także znany jako crawler, spider, lub bot) to skrypt lub silnik, który przegląda strony internetowe i pobiera z nich informacje, takie jak treść, linki, obrazy i inne zasoby. Roboty internetowe są wykorzystywane przez wyszukiwarki internetowe, takie jak Google, Bing czy Yahoo, aby indeksować strony internetowe i tworzyć ich katalogi.

Roboty internetowe działają automatycznie, odwiedzając strony internetowe i przeglądając ich zawartość. W trakcie tego procesu roboty wyszukują linki prowadzące do innych stron internetowych i przetwarzają informacje, takie jak meta tagi, nagłówki strony, treść i słowa kluczowe. Te informacje są następnie wykorzystywane przez wyszukiwarki internetowe do oceny jakości i ważności stron internetowych w celu wyświetlenia najlepszych wyników wyszukiwania dla użytkowników.

Kiedy warto blokować boty w robots.txt?

Na przykład, jeśli na jakiejś naszej stronie internetowej znajduje się podstrona lub katalog zawierający prywatne informacje o użytkownikach, takie jak:

- adresy e-mail,

- numery telefonów,

- loginy użytkowników,

- czy inne wrażliwe informacje,

Wtedy jak najbardziej przyda się umieścić plik robots.txt w tym katalogu, aby zablokować indeksowanie go przez roboty wyszukiwarek. W ten sposób prywatne informacje nie będą dostępne publicznie i nie zostaną zindeksowane przez wyszukiwarki.

Ale to nie wszystko. Warto też blokować przed dostępem robotów tam, gdzie znajduje się wiele stron z treścią duplikowaną lub bardzo podobną. Można zalokować roboty wyszukiwarek przed indeksowaniem tych stron, ponieważ mogą one prowadzić do niskiej jakości wyników wyszukiwania.

Możemy też użyć robots.txt do zmniejszenia obciążenie serwera. Jeżeli nie zależy nam na SEO, a na stronie internetowej znajduje się wiele zasobów, takich jak zdjęcia lub pliki multimedialne, które zajmują dużo miejsca na serwerze, można zablokować roboty wyszukiwarek przed indeksowaniem tych zasobów, aby zminimalizować obciążenie serwera.

Przykłady użycia robots.txt

Przykładowe umiejscowienie pliku: domena.pl/robots.txt lub inaczej /domains/domena.pl/public_html/robots.txt

User-agent: *

Disallow: /

W ten sposób informujemy wszystkie boty: User-agent o wartości * = wszystkie, nie zezwalać Dissalow: odwiedzenia lokalozacji katalog główny / i wszystko co się w nim znajduje.

User-agent: Googlebot

Disallow: /backup/

W powyższy sposób informujemy bota Googlebot aby nie zaglądał do katalogu /backup/

User-agent: Bingbot

Disallow: /blog/ja-na-plazy.html

W powyższy sposób informujemy bota wyszukiwarki Bing aby nie zaglądał na konkretny wpis z bloga.

User-agent: *

Disallow: /media/

Allow: /media/prezentacja.pdf

W katalogu /media/ znajdują się różne pliki. Chcemy aby aby tylko plik prezentacja.pdf miał zezwolenie na indeksowanie.

Teraz, skoro znasz już zasady możesz połączyć wpisy np.

User-agent: *

Disallow: /login/

Disallow: /admin/

Allow: /

User-agent: Googlebot-Image

Disallow: /media/

Allow: /media/prezentacja.pdf

Kolejność. W pliku robots.txt dyrektywa „Disallow” ma pierwszeństwo przed dyrektywą „Allow”. Oznacza to, że w przypadku konfliktu między tymi dwiema dyrektywami zastosowana zostanie dyrektywa „Disallow” czyli - nie zezwalaj. Niemniej jednak jeśli chodzi o kolejność, najlepiej najpierw blokować, a potem zezwalać.

Przykładowe nazwy botów:

Poniżej lista nazw botów, które możemy użyć przy budowie wpisów w pliku robots.txt

Googlebot: ogólny robot od GoogleGooglebot-Image: robot od obrazków GoogleGooglebot-Video: robot od video, od GoogleGooglebot-News: robot Google NewsBingbot: robot wyszukiwarki BingMSNBot-Media: robot wyszukiwarki Bing dla mediówSlurp: robot wyszukiwarki YahooYandexBot: robot ruskiej wyszukiwarki YandexDuckDuckBot: robot kaczuszy czyli wyszukiwarki DuckDuck

Warto jednak pamiętać, że blokowanie botów za pomocą pliku robots.txt nie jest w pełni skutecznym sposobem ochrony przed niepożądanymi robotami, ponieważ niektóre roboty wyszukiwarek mogą zignorować te instrukcje lub nie przestrzegać standardów, a także może to wpłynąć na indeksowanie niektórych ważnych stron lub zasobów.

Mapa strony w robots.txt

Możesz pomóc robotom w odkrywaniu i indeksowaniu większej liczby stron w witrynie podając im mapę strony dodając dodatkową dyrektywę w pliku robots.txt:

Sitemap: http://www.mojadomena.pl/post-sitemap.xml

Sitemap: http://www.mojadomena.pl/page-sitemap.xml

Wszystkie popularne wyszukiwarki internetowe, takie jak Google, Bing czy Yahoo, są w stanie indeksować witryny internetowe bez informacji o mapie witryny w pliku robots.txt. Jednak podanie adresu URL mapy witryny w pliku robots.txt pozwala na wykrycie i przetworzenie mapy witryny przez roboty wyszukiwarek w bardziej skuteczny sposób.

Jak utworzyć plik robots.txt

Aby utworzyć i edytować plik robots.txt najlepiej użyć menadżera plików dostępnego na hostingu. Przeczytaj nasz poradnik DirectAdmin - zarządzanie i tworzenie plików. lub możesz do tego celu użyć klienta FTP.

Tworzenie pliku za pomocą menadżera plików na hostingu.

Tworzenie pliku za pomocą menadżera plików na hostingu.

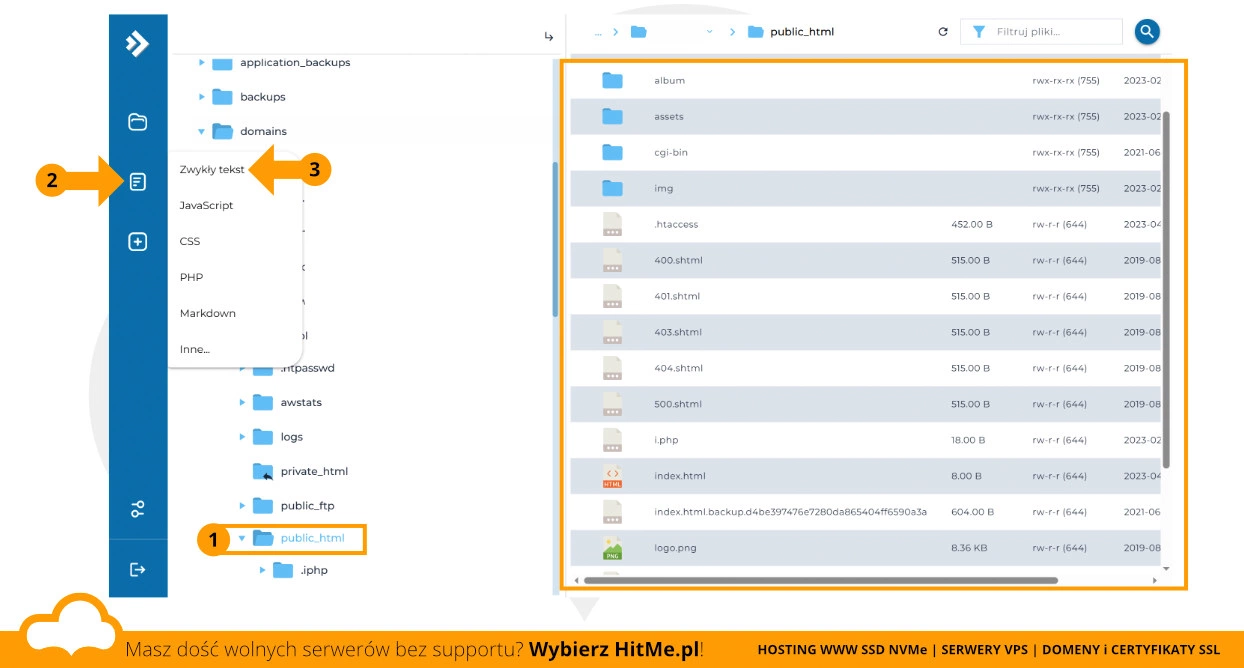

- (1) Wybierz katalog swojej domeny rozwijając drzewko np.

Moje Pliki/domains/**nazwa domeny**/public_html/ - (2) Kliknij Utwórz plik, po czym wybierz z menu typ pliku: (3) zwykły tekst

- następnie nadaj nazwę dla pliku np.

robots.txt - po kliknięciu Utwórz zostanie utworzony pusty plik, który teraz możesz edytować.

Jak przetestować plik robots.txt

Aby przetestować plik robots.txt możesz użyć testera od Google lub testera od Bing jednak w obydwu przypadkach wymagana jest uprzednia rejestracja darmowej usługi.

Nie przesadzaj tylko z ilością wpisów, limit pojemności robots.txt to 512kb.